Hosting

Od piramid do chmury – historia backupu cz.1

Ludzie dzielą się na tych, którzy robią kopie bezpieczeństwa i tych, którzy będą je robić. Historia backupu pokazuje, że nasi przodkowie zaliczają się do pierwszej grupy.

Ryzyko utraty cennych informacji nie pojawiło się jednak wraz z komputerami. Klęski żywiołowe, wojny i pożary od wieków groziły ludziom i wiedzy zapisanej na papirusach, kartach ksiąg lub innych nietrwałych nośnikach.

Chcesz wypożyczyć zwój? Daj swój do skopiowania

Kopie zapasowe są niemal tak stare, jak pismo. Już 1 500 lat przed naszą erą egipscy, faraonowie zakładali królewskie biblioteki gromadzące cenne papirusy. To jednak mniej trwały materiał niż papier, dlatego najważniejsze informacje były zapisywane hieroglifami na ścianach piramid. Dzięki temu przetrwały do naszych czasów. Można je zatem uznać za pierwszą formę skutecznego backupu.

Równie duży wpływ na rozwój praktyk zachowywania treści miała helleńska dynastia Ptolemeuszy. Stworzyli oni Bibliotekę Aleksandryjską, której celem było zgromadzenie dorobku naukowego i literackiego antycznego świata.

Księgozbiór zgromadzony był w dwóch miejscach: Serapejonie, znajdującym się przy świątyni Serapisa, i Bruchejonie przy pałacu królewskim. Zwoje studiowali i gromadzili mędrcy. Zbiory Serapejonu były powszechnie dostępne dla ludu, a pracujący tam kapłani kopiowali je. Podróżni chcący skorzystać z księgozbioru przekazywali posiadane dzieła do skopiowania. W ten sposób zasoby rosły.

Biblioteka w Aleksandrii przyczyniła się do uratowania spuścizny literackiej i naukowej starożytnej Grecji. Wszystko dzięki wspaniałomyślności królów egipskich, którzy czuli na sobie obowiązek zachowania skarbów przeszłości. Nie można też zapominać o wysiłku uczonych, którzy dzieła klasyfikowali i przepisywali.

Co pozwoliło przetrwać księgozbiorowi w Aleksandrii niemal milenium? To z pewnością separacja na dwie lokalizacje i procedura nieustającego kopiowania danych. Z podobnych mechanizmów korzystamy do dziś.

Kopia zapasowa króla Franciszka

Przez wiele stuleci utrwalanie wiedzy wyglądało podobnie. Miejsce egipskich kapłanów zajęli mnisi. Zamiast jednej biblioteki powstawało ich mnóstwo, głównie przy klasztorach i uniwersytetach. Metoda pozostała jednak niezmieniona – to ludzie przepisywali tekst ręcznie aż do XV wieku.

W 1450 roku wszystko się zmieniło. Johannes Gutenberg opracował maszynę drukarską z ruchomymi czcionkami. Wynalazek pozwolił na masowe kopiowanie treści, z której postanowił skorzystać król Francji.

W 1537 roku Franciszek I ustanowił pierwszy na świecie egzemplarz obowiązkowy. To przepis mówiący, że jedna sztuka każdej wydanej na terenie królestwa księgi miała trafiać do królewskiej biblioteki. Francuską metodę backupu wkrótce podchwyciły inne europejskie państwa. W wielu z nich egzemplarz obowiązkowy stał się prawem, które uchroniło przed utratą wiele ważnych dzieł.

8 000 ton danych

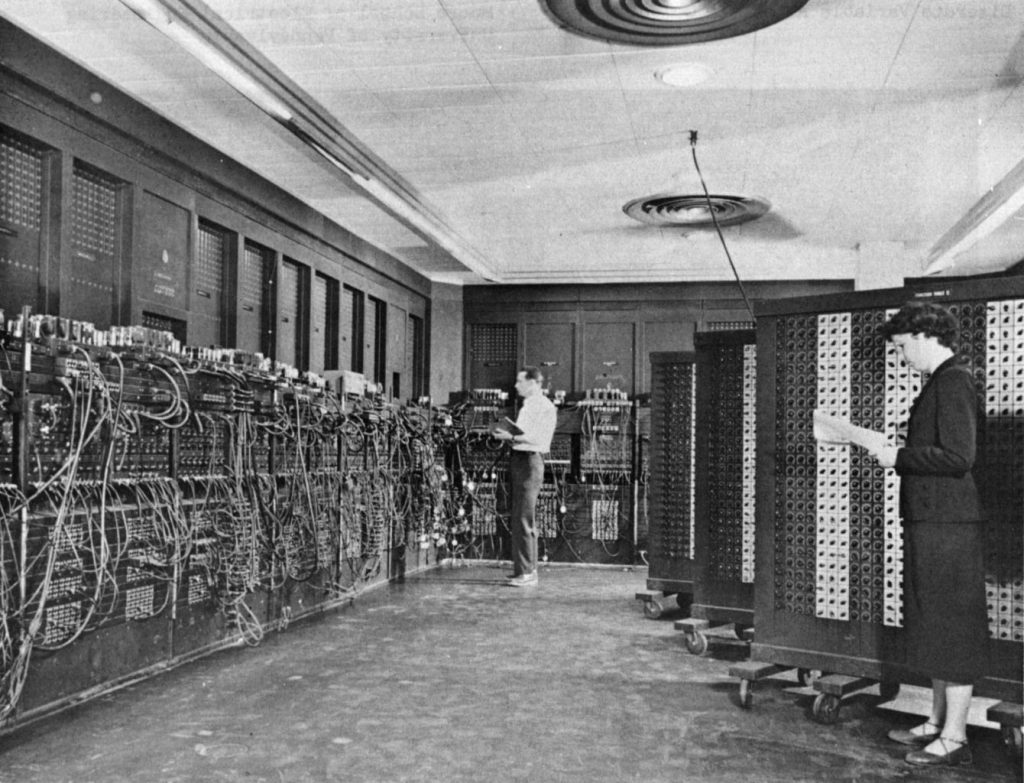

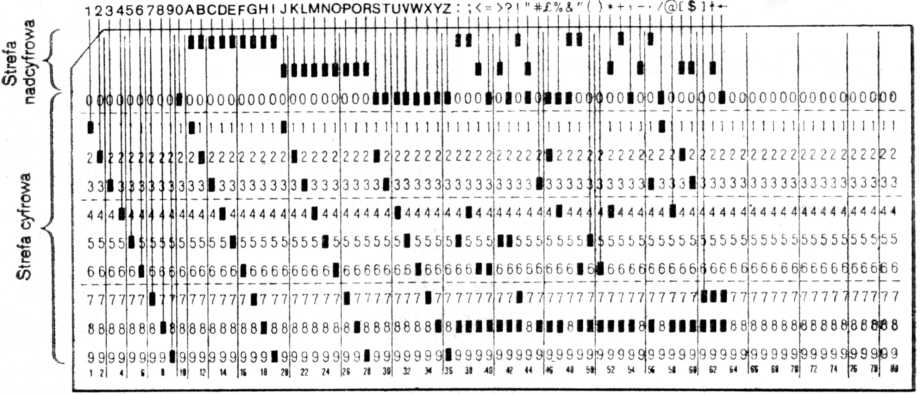

W czasach, gdy pierwsze komputery zajmowały kilka pomieszczeń i częściej były wykorzystywane do celowania artylerią niż oglądania zdjęć kotków, druk wciąż był najlepszym backupem. Książkę można bowiem przeczytać setki lub tysiące razy w przeciwieństwie do kart perforowanych.

Po kilkunastu odczytach karty zużywały się i przestawały działać prawidłowo. Mimo to wykonywano na nich kopie zapasowe z braku innego rozwiązania. Najpopularniejszy format kart wprowadził IBM. Miały 80 kolumn z pojedynczym znakiem i prostokątne otwory. Każdy znak odpowiadał jednemu bajtowi. Pojedyncza karta miała 0,18 mm grubości.

Możemy zatem obliczyć, że do zakodowania 320 GB standardowej pojemności dysku twardego potrzebny byłby stos kart o wysokości ponad 720 kilometrów i ważący ponad osiem tysięcy ton. Niezbyt wydajnie, prawda?

Magnetyzm danych

W latach sześćdziesiątych pojawiła się szybsza i wydajniejsza technologia zapisu. Jedna rolka taśmy magnetycznej pozwala przechować tyle danych, co 10 000 kart perforowanych. W tym czasie komputery stawały się coraz popularniejsze w firmach i ośrodkach akademickich. To z tego okresu pochodzą pierwsze procedury tworzenia backupów.

W 1956 roku IBM przedstawił światu pierwszy komputer z dyskiem twardym o pojemności… 5MB i rozmiarów sporej szafy. Wkrótce jednak rozmiary dysków zaczęły maleć, podczas gdy ich pojemność rosła. W końcu dyski twarde stały się standardem przyjętym przez innych producentów i najpopularniejszym nośnikiem kopii zapasowych w dużych firmach i instytucjach. Wcześniej przegrywały z taśmami magnetycznymi ze względu na niekorzystny stosunek pojemności do rozmiarów i ceny.

Kolejnym ważnym krokiem było opracowanie technologii RAID (z ang. Reduntant Array of Independent Disks). Nadmiarowa macierz niezależnych dysków, dzięki zapisowi danych na kilku niezależnych nośnikach, wyraźnie podniosła niezawodność w stosunku do pojedynczych HDD.

Użytkownicy prywatni i małe firmy, ze względu na cenę do backupów używali dyskietek. Pierwsze modele mogły pomieścić zawrotne 80 KB danych i miały przekątną 8 cali (20,3 cm). Pojemność ta systematycznie rosła, aby w latach 90-tych osiągnąć maksymalnie 250 MB na 3 calach (7,6 cm). Wtedy dyskietki zostały wyparte przez płyty CD i pamięć flash.

Duże firmy wykorzystują też dyski magnetoptyczne. To krążki z tworzywa sztucznego pokrytego warstwą materiału magnetycznego, zabezpieczone kasetą z plastiku lub szkła. Wyglądem przypominają hybrydę dyskietki i płyty CD. Mają pojemność od 128 MB do 9,1 GB. Największą ich zaletą jest odporność na działanie sił pola elektromagnetycznego i gwarancja dostępu do danych określana na kilkadziesiąt lat.

W profesjonalnych centrach danych pliki przechowuje się na macierzach synchronizowanych między sobą. Przykładowo nowy produkt Kei.pl – Dedykowana Infrastruktura IT – zapisuje dane klienta synchronicznie na dwóch macierzach połączonych w oparciu o sieć InfiniBand. Każdy plik klienta znajduje się na minimum czterech dyskach fizycznych.

Jeśli zainteresowała Was historia backupu C.D.N.

Poczytaj więcej na naszym blogu

-

Nowa wersja WordPressa 2022

24 maja 2022 r. pojawiła się nowa wersja WordPressa – 6.0. Jest to druga duża wersja wydana w tym roku. Sporo się zmienia. […] -

Przyśpieszenie strony dzięki konwersji zdjęć na WebP

Przyspieszenie ładowania się stron www to oczko w głowie tak wielu specjalizacji (SEO, UX, CRO, PPC), że nic dziwnego co chwila pojawiają się nowe sposoby […]